近日在比利时布鲁塞尔举办的2019年AutoSens大会不乏技术创新,技术开发商、汽车Tier 1以及原始设备制造商(OEM)都在探索能够稳健地应对任何道路状况的环境感知技术,例如黑夜、雨雾、风雪、道路冰冻等。

汽车产业尚未找到一剂通用的“灵丹妙药”,各个公司都推出了它们自己的新感知技术或产品概念。

据麦姆斯咨询报道,今年AutoSens大会的重点聚焦在了高级驾驶辅助系统(ADAS)而非自动驾驶汽车(AV)。

很明显,业界不再否认,目前可以达到的技术与最终推出的商业化人工智能(AI)驱动自动驾驶汽车(真正的无人驾驶)之间仍然存在着巨大的现实差距。

当然,需要指出的是,没有人说自动驾驶汽车是不可能实现的。但是,据VSI Labs创始人兼负责人Phil Magney预测:“Level 4自动驾驶汽车将在严格限制的运营设计空间内推出,并基于非常完整且详尽的安全案例。我的意思是指特定的道路、特定的车道、特定的运营时间、特定的天气状况、特定的时段、特定的上下车地点等。”

康奈尔大学(Cornell University)计算机科学教授Bart Selman在AutoSens闭幕小组会议上谈及人工智能驱动汽车是否能获得“通常的感知理解(知道它实际上是在驾驶汽车并理解它的行车环境)”能力时,说:“这距离我们至少有10年时间,也可能是20~30年。”

在此同时,对于那些希望构建ADAS和高度自动化汽车的厂商,目前的主旋律是如何使车辆获得最佳的“视觉”。

卡内基梅隆大学(Carnegie Mellon University)教授、Edge Case Research首席技术官Phil Koopman指出,所有高度自动化车辆的基础都是“感知”——知道周围的物体分别在什么位置。他解释说,与人类驾驶员相比,自动驾驶汽车的弱势是“预测”,即了解行车环境并预测感知到的物体下一步可能去往何处。

边缘智能

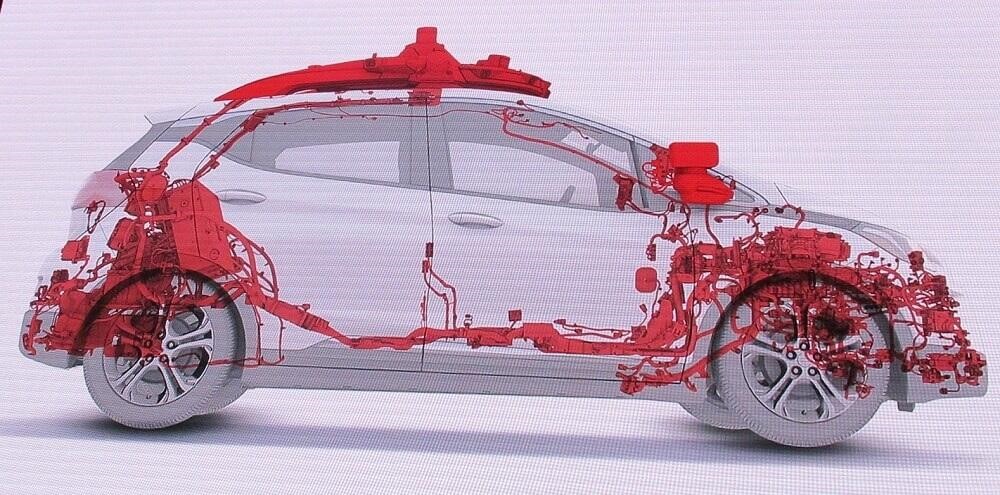

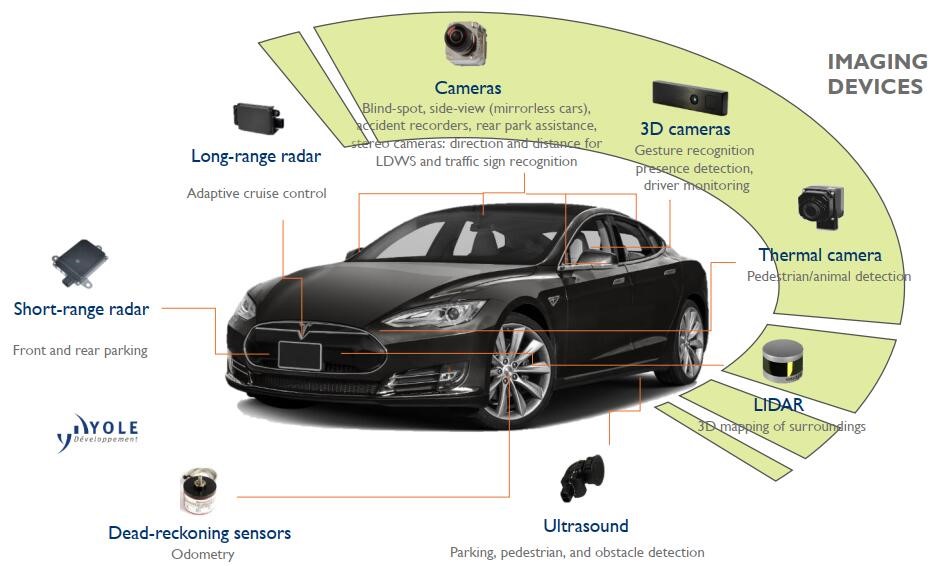

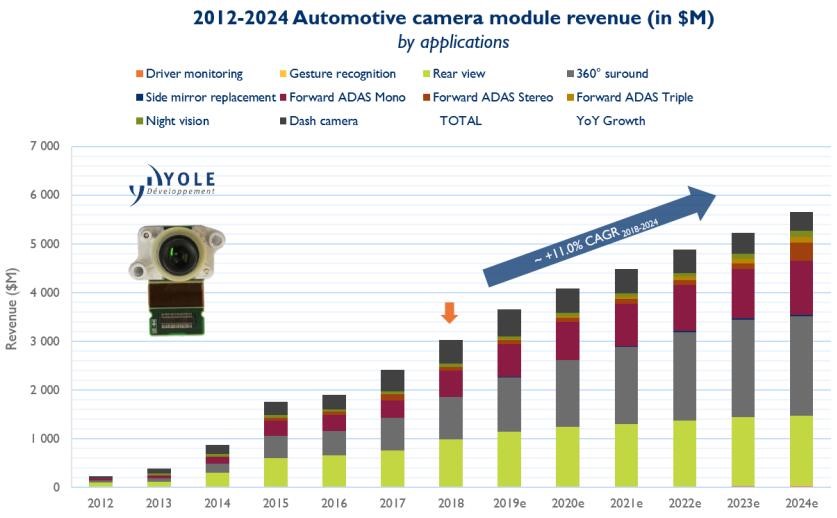

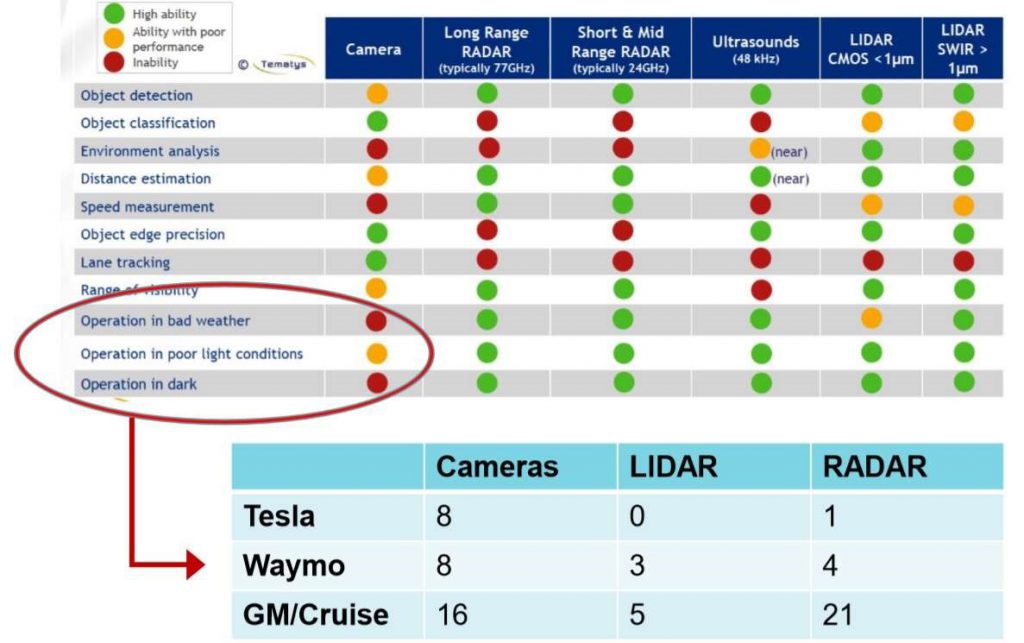

AutoSens大会上新涌现出的一种趋势,是为车辆增加更多的边缘智能。许多供应商通过在边缘融合不同的传感器数据,例如“RGB摄像头+近红外(NIR)传感”、“RGB摄像头+短波红外(SWIR)传感”、“RGB摄像头+激光雷达(LiDAR)”、“RGB摄像头+雷达”等等,在边缘传感节点上增加更多的智能。

数据来源:《汽车成像-2019版》

不过,产业对于如何实现这一目标还存在分歧。有些厂商选择在边缘促进传感器融合,另外一些厂商(例如Waymo),则更倾向于在中央处理单元对原始传感数据进行集中融合。

到2020年,欧洲新车评价规程(NCAP)要求驾驶员监控系统(Driver Monitoring System, DMS)纳入主要安全标准。在AutoSens大会上已经出现了许多新的监控系统。这些系统不仅可以监视驾驶员,还可以监视车内的乘客或其它物体。

其中的一个典型例子便是安森美半导体(On Semiconductor)展示的新型RGB-IR图像传感器,整合了Ambarella的先进RGB-IR视频处理片上系统(SoC)和Eyeris的车载场景理解AI软件,能够执行复杂的人体和面部分析、乘客活动监控和物体检测。

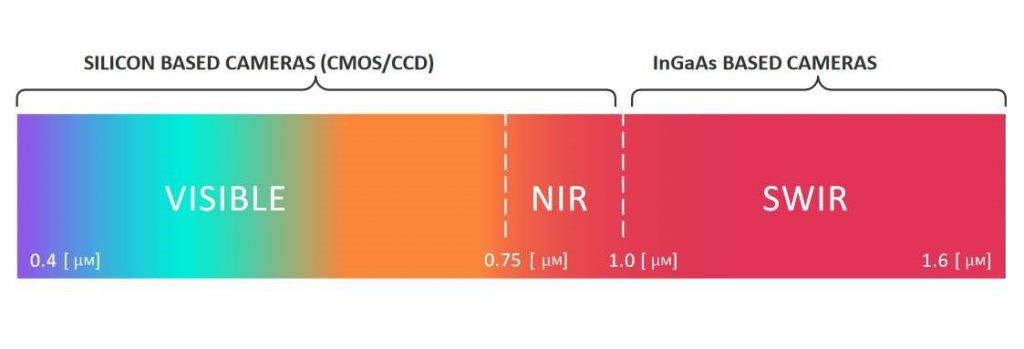

近红外 vs. 短波红外

无论是车内还是车外,都需要在黑暗中获得视觉能力,这意味着需要利用红外(IR)技术。

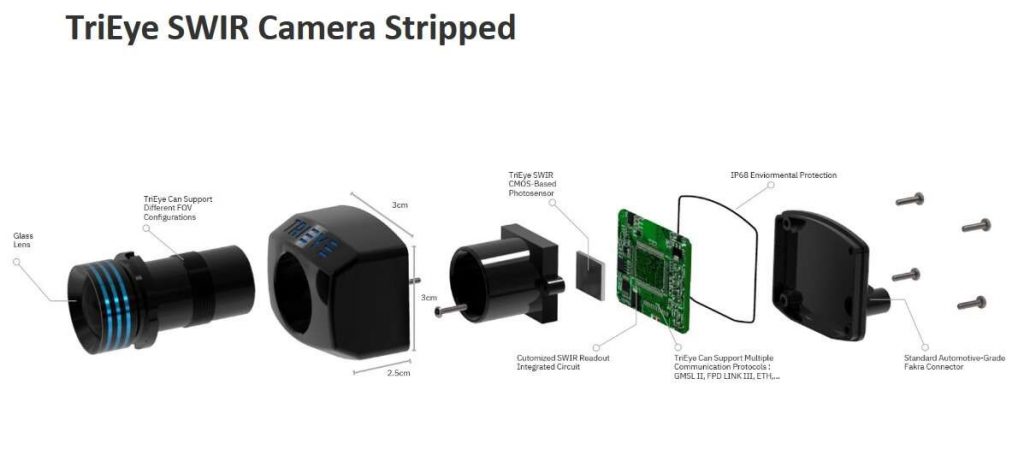

安森美半导体的RGB-IR图像传感器采用了NIR(近红外)技术,另一家参会厂商Trieye则通过展示的短波红外(SWIR)相机,又迈进了一步。

SWIR的优势在于能够在任何天气/光照条件下看到物体。更重要的是,SWIR还可以提前识别道路危险(例如道路结冰),因为SWIR可以检测到每种材料由化学和物理特性所决定的独特光谱响应。

然而,由于制造SWIR相机的铟镓砷(InGaAs)成本极高,因此它大多还仅限于军事、科学和航空航天应用。不过,Trieye声称,它们已经开发了一种使用CMOS工艺技术设计SWIR的方法。

“这就是我们取得的突破。从一开始,我们就像半导体一样将CMOS用于SWIR相机的大批量生产。”Trieye首席执行官兼联合创始人Avi Bakal说,“与价格超过8000美元的InGaAs传感器相比,Trieye推出的SWIR相机价格将会在‘几十美元’左右。”

缺乏标注数据

人工智能的最大挑战之一是训练数据的不足。具体来说是“标注的训练数据”,Magney说,“推理模型的构建需要基于数据及其收集方式。当然,训练数据需要用元数据标注,这非常耗时。”

在本届AutoSens大会上,业界就对抗生成网络(generative adversarial networks, GAN)方法进行了热烈的讨论。据Magney称,对抗生成网络,顾名思义就是两个神经网络“竞争”以创建新数据。对于给定的训练集,据报道,该技术将学习生成具有与训练集相同统计数据的新数据。

例如,Drive.ai公司正在使用深度学习来增强数据标注的自动化,以加速繁琐的数据标注过程。

在AutoSens的一次演讲中,Koopman也谈到了准确标注数据的巨大挑战。他怀疑很多目前的测试数据仍然没有标注,因为只有少数大公司能够负担得起。

确实,参会的AI算法初创公司承认了第三方标注数据的费用之痛。

GAN是一种方法。但是,Edge Case Research提出了另一种无需标注所有数据即可加速更安全感知软件开发的方法。该公司最近发布了一种名为Hologram的工具,该工具提供了AI感知压力测试和风险分析系统。据Koopman称,无需标注数拍字节(Petabytes)的数据,运行两次Hologram就可以提供提示,哪些地方有问题,或者哪些地方需要通过收集更多数据或执行更多训练来重复改善。

会议上讨论的另一个问题是,如果汽车OEM更换用于数据训练的摄像头和传感器,带标注的数据集会发生什么情况。

Algolux营销和战略合作伙伴关系副总裁David Tokic表示,从事ADAS和AV的汽车工程师关注两件事:1)所有条件下的稳健感知;2)准确且可扩展的视觉模型。

如今,ADAS或AV中应用的典型摄像头系统各不相同,且差异很大,取决于它们的镜头(不同的镜头提供不同的视场)、传感器和图像信号处理,因此参数都不同。一家公司选择一种摄像头系统,收集大数据集,并对其进行标注和训练,以构建可调整适配系统的准确神经网络模型。

但是,当OEM更换最初用于训练数据的摄像头时会怎样?这种变化可能会影响感知准确性,因为已为原摄像头调整的神经网络模型现在需要处理一组新的原始数据。

这是否需要OEM重新训练其数据集?

谈及图像传感器的更换,VSI Labs的Magney说:“除非规格相同,否则我不认为这是一个好选择。例如,在VSI,我们为FLIR热像仪训练了自己的神经网络,训练图是用与我们采用的相同规格的热像仪收集的。我们后来更换了传感器,但更换的是规格相同的传感器。”

人工智能(AI)硬件

过去几年中诞生了许多新的AI处理器初创公司,掀起了AI热潮,引领业界发出硬件复兴的呼声。并且,许多AI芯片初创公司都将ADAS和AV做为目标市场。

针对这一新兴的AI加速器市场,AI处理器初创公司之一Ceva在AutoSens会议上首次展示了该公司的新AI核心和“Invite API”。

不过,奇怪的是,新一代功能丰富的车型还未真正启用这些新的AI芯片,除了Nvidia、Intel/Mobileye设计的芯片,以及特斯拉开发的“全自动驾驶(FSD)计算”芯片等供它们自己使用的芯片。

另一方面,安森美半导体在AutoSens上发布的“RGB +红外”摄像系统,表明安森美半导体/Eyeris团队选择了Ambarella的SoC作为其AI处理器来执行车载监控任务。

Eyeris首席执行官Modar Alaoui承认Ambarella似乎不被认为是一支AI加速器开发团队,而是传统的视频压缩和计算机视觉芯片公司,他说:“我们没有能找到可以支持10个神经网络、功耗不到5瓦,并能使用多达6个摄像头(拍摄车内)捕捉每秒30帧视频的AI芯片,以运行Eyeris的AI车载监控算法。但是,Ambarella的CV2AQ SoC能够满足我们的要求,击败了所有其它正在热炒的AI加速器。”

不过,Alaoui希望,在明年1月拉斯维加斯举行的CES消费电子展之前,他们公司的AI软件算法可以应用到另外三家硬件平台上。

同时,安森美半导体强调,驾驶员和乘员监控应用需要具有从阳光直射到黑暗的可变光照下捕获图像的能力。安森美半导体声称,凭借其良好的近红外响应,新发布的RGB-IR CMOS图像传感器利用3.0 µm背照式(BSI)和三重曝光HDR技术,可提供全高清1080p输出。其传感器对RGB和IR光均敏感,可以在日光下捕获彩色图像,在NIR照明下捕捉单色IR图像。

超越驾驶员监控系统(DMS)

Alaoui声称Eyeris的AI软件可以执行复杂的人体和面部分析、乘客活动监控和物体检测。除了驾驶员监控之外,Eyeris的AI软件还可以监控汽车内部的所有事物,包括座椅表面和方向盘。Alaoui表示他们的AI软件已经超越了Seeing Machines公司所能达到的性能。

Seeing Machines公司欧洲客户解决方案主管Laurent Emmerich不敢苟同。他说:“突破驾驶员监控,并覆盖车辆内部是自然而然的发展方向。我们也正在这个方向发力。”

他补充说,与初创公司相比,Seeing Machines的优势在于过去20年来AI专业知识在计算机视觉方面的积累。目前,该公司的驾驶员监控系统已被6家汽车制造商成功应用到9个项目中。

此外,Seeing Machines公司还表示,它们也开发了自己的硬件——Fovio驱动监视芯片。当被问及该芯片是否还可以服务于未来的车载监控系统时,Emmerich解释说,其芯片IP将应用于可配置的硬件平台。

感知冗余

将多种不同形式的传感器组合装配在车辆中,不仅可以提升车辆感知能力,还可以提供安全性必须的感知冗余。

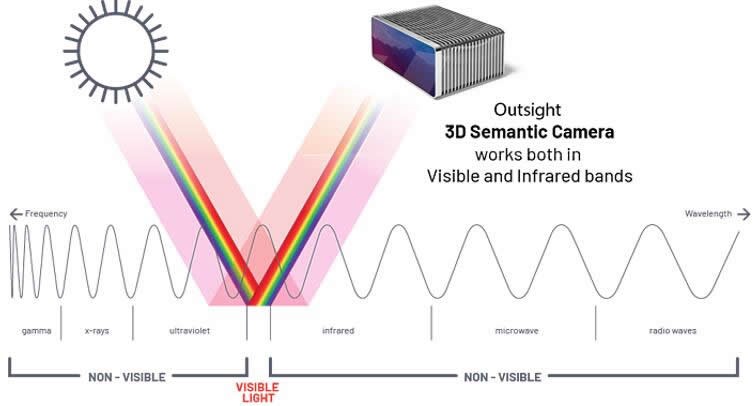

据麦姆斯咨询此前报道,由前Whitings首席执行官Cedric Hutchings共同创立的初创公司Outsight在AutoSens上推出了一款由多个传感器组成的高度集成的3D语义相机(3D Semantic Camera)。这款相机采用低功率短波红外(SWIR)激光器,能够像激光雷达一样扫描周围数百米的范围。结合Outsight的算法,这款3D语义相机不仅可以实时“看到”车辆周围的整个环境,还能够识别冰、油和皮肤等物体材料。

对于Outsight的3D语义相机中整合了哪些厂商的传感器,Cedric Hutchings拒绝发表评论。“由于我们仍在针对合适的规格参数和应用进行调试,因此我们目前不会公布我们的主要合作伙伴。”

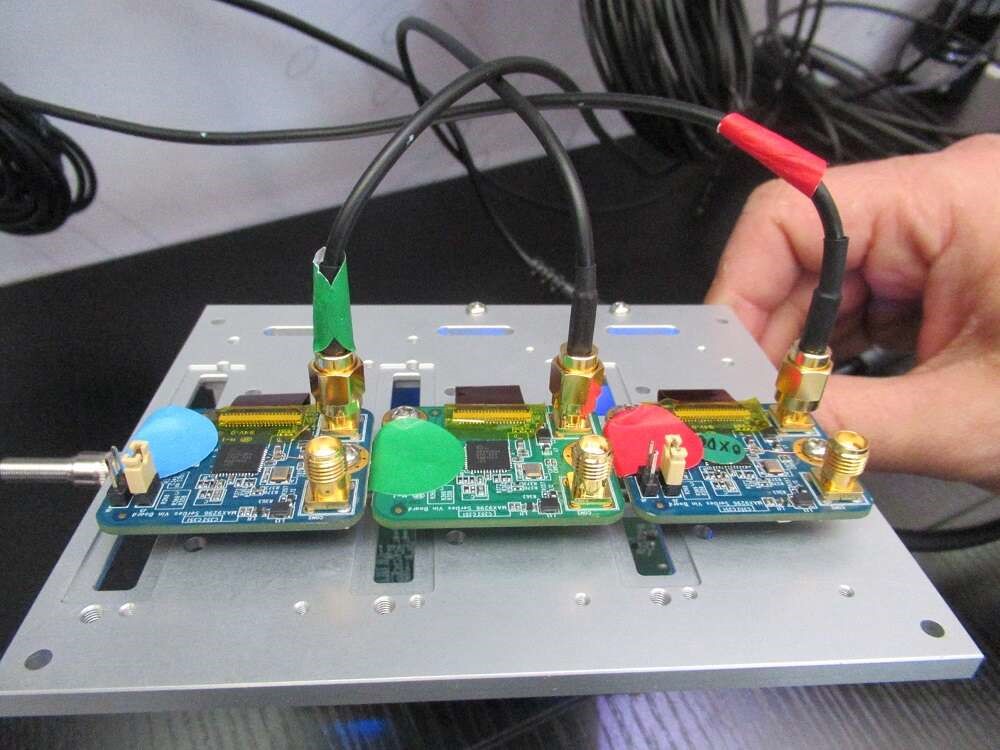

不过,随后Trieye在会上透露,Outsight将会采用Trieye的SWIR相机。Outsight的3D语义相机能够通过板载SoC,在不依赖“机器学习”的前提下,提供可操作的信息和对象分类,从而降低了系统所需要的功耗和带宽。这款3D语义相机计划于2020年第一季度出样。

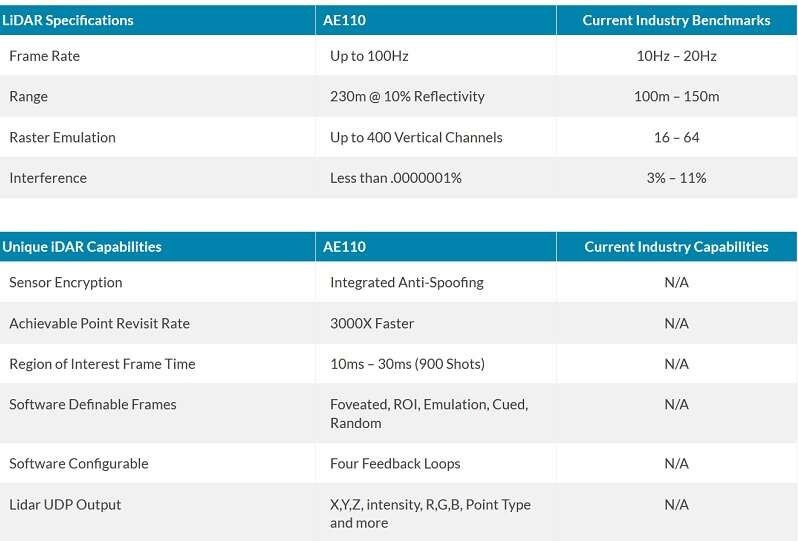

另外一家初创公司Aeye也在为ADAS/AV市场推销其iDAR——一款融合了高清摄像头的固态MEMS激光雷达。AEye产品管理副总裁Aravind Ratnam表示,通过组合两种传感器并嵌入AI,这款实时运行的系统可以解决某些极端情况。

Aeye公司解释称,iDAR系统旨在将2D摄像头RGB像素和3D激光雷达的“体素”(XYZ)相结合,以提供一种新的实时传感数据类型,以更快的速度为自动驾驶车辆的路径规划系统提供更准确、范围更广、更智能的环境信息。

Ratnam在演讲中说,“AEye研究了300多个场景,选择了56个适用案例,并将它们进一步缩小到20个场景,在这些情况中,融合了摄像头、激光雷达和AI的感知系统最有意义。”

Ratnam展示了一个场景,在这个场景中,一名儿童将球拍到了街道上并追上了街道,而车辆正在驶来。在这个场景中,处于边缘的摄像头与激光雷达融合可以更快地工作,从而缩短了车辆的反应时间,更快的完成车辆制动。他指出:“我们的iDAR平台可以提供非常快的计算速度。”

谈及边缘传感器融合的优势,一位Waymo工程师表示,他不确定是否能带来实质性的改变。他提出:“边缘融合带来的速度提升是微秒量级吗?我不确定。”

AEye对其iDAR可以为Tier 1提供的附加价值充满信心。通过与关键合作伙伴海拉(Hella)和LG的紧密合作,AEye表示已经能够大幅降低LiDAR的成本,现在能够以ADAS的价格提供3D激光雷达。

AEye将在接下来的3~6个月内完成嵌入AI的车规级RGB摄像头和激光雷达系统组合,并且价格将“低于1,000美元”。

IHS Markit预测的汽车激光雷达出货量 IHS Markit汽车半导体和传感器高级分析师Dexin Chen向与会者表示,激光雷达开发商一直在“过度营销,吹嘘性能。”他指出,“展望未来,激光雷达带来的物理参数优势可以宣传,但是否能真正商业化才是决定性的。这个领域非常需要的是,标准化、联盟和伙伴关系,供应链管理以及AI合作伙伴。”